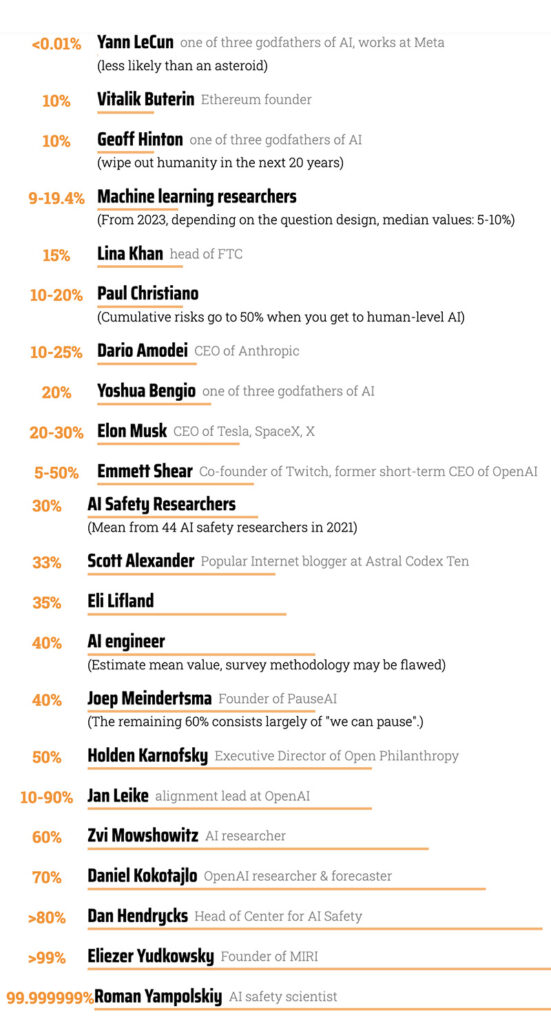

P(Doom) è l’indice che rappresenta la probabilità che la AI porti all’estinzione umana. Ci sono anche altri scenari che possono essere definiti come catastrofici. Un esempio potrebbe essere la morte di una vasta parte della popolazione a seguito di un’arma biologica sviluppata mediante l’intelligenza artificiale, il crollo sociale causato da un attacco informatico di ampia portata, o l’intelligenza artificiale che innesta una guerra nucleare. Nell’immagine, in fondo all’articolo, vedete la classifica in percentuale, da 0% rischio minimo a 100% estinzione certa. P(Doom) per ora è una narrazione della Silicon Valley e di qualche importante giornale statunitense e poco più, ma nella classifica si esprimono i più grandi ricercatori e produttori di AI. Da Yann le Cunn (AI Meta) che vede l’estinzione con meno dello 0,01%, passando al 10% di Geoff Hinton (uno de padri della AI) per arrivare al 99,9% di Roman Yampolskiy (Direttore del Cyber Security Lab dell’Università di Louisville)

La UE da sempre in primo piano per la sicurezza dei suoi cittadini ha approvato poche settimane fa l’AI Act. Il regolamento definisce un quadro giuridico per l’uso e la governance dell’intelligenza artificiale all’interno dell’Unione Europea. Il principio su cui si basa è quello di garantire la sicurezza ai cittadini europei nell’uso e nello sviluppo dell’intelligenza, “cosiddetta”(Papa Francesco) artificiale. Ormai questo è il metodo che la UE ha adottato o forse subito; gli USA sviluppano e producono la AI e il digitale, la Cina e l’India la copiano e provano a fare meglio e la UE definisce il quadro giuridico. Lo ha fatto per la privacy con il GDPR, con il Digital Services Act per i servizi digitali e ora con l’AI Act per l’intelligenza artificiale.

Su quali dati, su che esperienze, in breve perché la UE ha definito un regolamento AI che si basa principalmente sulla sicurezza e sulla restrizione?

Secondo un nuovo studio condotto dall’Emerging Technology Observatory della Georgetown University la sicurezza dell’AI rappresenta solo il 2% della ricerca complessiva sull’intelligenza artificiale. Dei 172.621 articoli di ricerca sull’intelligenza artificiale pubblicati ad esempio da autori americani tra il 2017 e il 2021, solo il 5% riguardava la sicurezza. Mentre la Cina ha solo l’1% delle ricerche pubblicate incentrate sulla sicurezza dell’IA.

Il 40% degli articoli relativi alla sicurezza dell’AI nel set di dati utilizzati erano di ricercatori americani, Il 12 % di autori cinesi e il 19 % di quelli europei. Mentre i principali 5 paese al mondo in cui si fa ricerca sulla sicurezza della AI sono Usa, Cina, Regno Unito, Germania e Canada. Anche qui poca Europa. Delle prime 10 organizzazioni di ricerca o di impresa leader sulla sicurezza della AI, 8 sono Usa e 2 cinesi. La UE dunque ha seguito unicamente il framework narrativo della paura della AI decidendo per una regolamento di questo tipo? Oppure non poteva fare null’altro senza aziende e investimenti significativi nel sistema AI? Di certo aveva pochi dati e poche ricerche per decidere come regolamentare, come testimonia la ricerca dell’Emerging Technology Observatory. Quali di questi ha usato per definire il regolamento?

Mentre il programma nazionale sulle risorse degli Usa per la ricerca sull’intelligenza artificiale mira ad aggiungere più potenza di calcolo per i ricercatori lo stesso non succede con convinzione nella UE. E tra l’altro queste misure non riescono nemmeno a tenere il passo con i progressi compiuti dall’industria della AI. Le grandi aziende tecnologiche stanno costruendo supercomputer e cercando grandi investimenti per svilupparli. Per mettere le mani su questo tipo di potenza di calcolo, i ricercatori sulla sicurezza dell’intelligenza artificiale dovranno lavorare per forza per quelle aziende abbandonando la ricerca pubblica. Appare dunque poco logico che la Ue approvi norme stringenti sull’intelligenza artificiale senza contemporaneamente promuovere un significativo incremento dei finanziamenti, destinati per ora alla morte, per la ricerca sulla sicurezza e in generale della AI, inclusi gli importanti fondi che dovrebbero essere destinati alla potenza di calcolo necessaria per i ricercatori impegnati nello studio di nuovi modelli di intelligenza artificiale.

La sicurezza della AI rimane un tema centrale per le comunità della terra; il regolamento UE contiene alcuni principi fondamentali per il rispetto dei diritti umani. Vieta il social score, il riconoscimento facciale per usi di polizia ma discriminando ad esempio tra migranti e cittadini europei, e altre restrizioni che tutelano la persona. Tutto questo ovviamente non vale se di mezzo ci sono le armi o gli scopi militari; questi non ricadono sotto l’ombrello dell’AI Act

Il processo con cui è stato pensato, costruito e approvato pare per ora davvero incerto, costruito in un unico frame narrativo e quindi anche deliberativo; speriamo non inutile e controproducente.

Altri dati e il metodo di ricerca usato lo potete trovare qui.

Emerging Technology Observatory della Georgetown University è finanziato da Open Philantropy, una fondazione di ricerca e finanziamento di Dustin Moskovitz co-fondatore di Facebook .