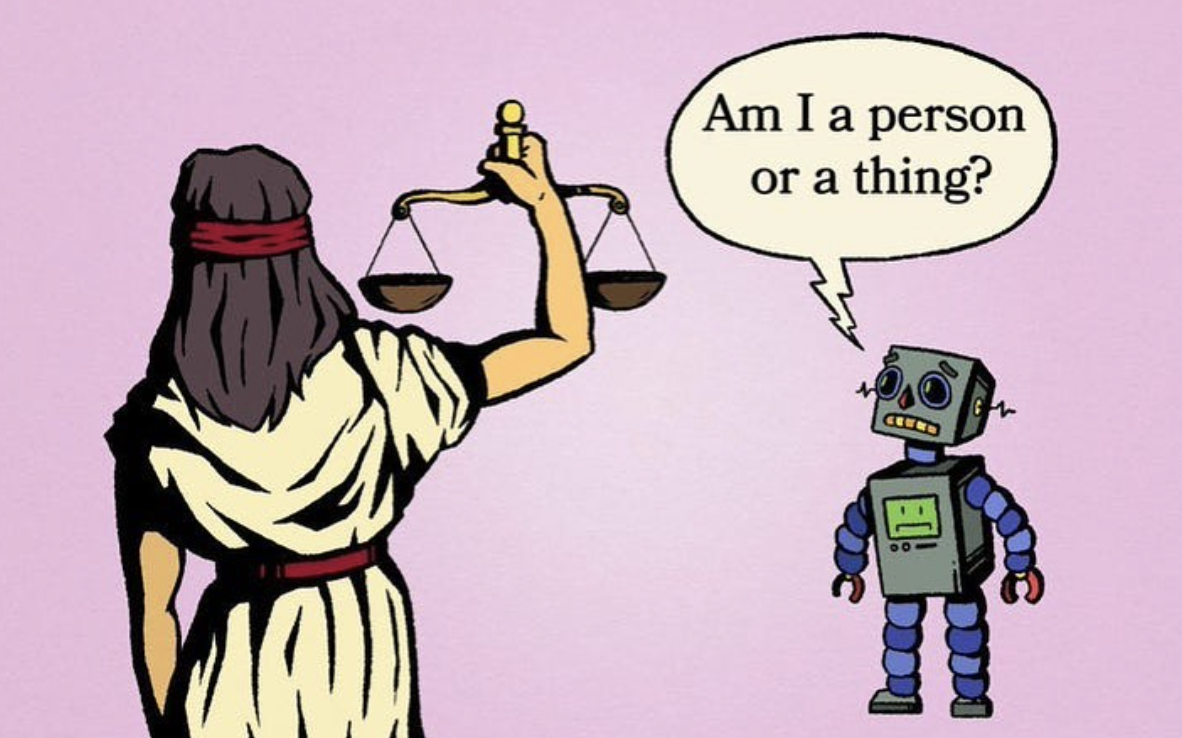

LaMDA, che sta per “Language Model for Dialog Applications”, è uno dei numerosi sistemi di intelligenza artificiale su larga scala e è addestrato a rispondere alle nostre domande su ampie porzioni di testo, in gran parte uno scraping dal Web, per lo più in inglese e pare con poco controllo della qualità dell’informazione. E’ simile a GPT-3 di OpenAI e a tanti altri. E riesce a elaborare qualcosa come 1,5 trilioni di parole di testo. Con numeri cosi alti è impossibile verificare come gli algoritmi rispondano e questo può far apparire comportamenti senzienti, quindi non programmati. Il ricercatore che, dopo una discussione con LaMDA, ha affermato essere convinto di parlare con una Ai senziente come un bambino di 8 anni è stato messo in congedo da Google per aver violato la politica di riservatezza dell’azienda. Google sta spingendo molto verso l’utilizzo di modelli linguistici al posto dei motori di ricerca e questo per molti ricercatori danneggerà l’alfabetizzazione delle persone. Un modello linguistico espone in forma sintetica stringhe di parole per restituire una frase in risposta alla domanda fatta ma non può risolvere le fonti di informazione. In altre parole non possiamo valutare le origini delle informazioni per cui la Ai risponde. Per ora affermare che la AI è senziente è davvero complicato e gli esperti tendono a escluderlo; ma per molti è importante farlo credere. Molta stampa, i ricercatori e i venture capitalist si occupano di affermazioni esagerate sulla super intelligenza o sulla cognizione umana nelle macchine. Esiste un divario piuttosto ampio tra l’attuale narrativa dell’IA e ciò che può effettivamente fare. La narrazione che facciamo della AI, distrae dalle innumerevoli questioni etiche e di giustizia sociale poste dai sistemi di intelligenza artificiale. E ricondurre poi la storia su come stanno davvero le cose sulla AI occupa tanta energia. La tecnologia e chi la produce corre molto più velocemente, spesso irresponsabilmente, della narrazione consapevole che ne facciamo. Ma piuttosto che riconoscere ai robot una personalità giuridica come ha provato a fare la UE nel 2017, possiamo, dobbiamo, iniziare a chiedere a chi sviluppa questi algoritmi trasparenza sui processi, per cosa sono stati addestrati, quali dati sono stati utilizzati, chi ha scelto quei dati e per quale scopo quella tecnologia è stata sviluppata.

Gli algoritmi della AI sono senzienti solo nel momento in cui noi coscientemente crediamo che lo siano. E questo è quello che ora molti postumanisti vogliono farci credere.